Nature:人工智能即将面临数据枯竭的困境

人工智能的发展近年来取得了显著的进展,特别是神经网络的规模和训练数据的增加。然而,这种扩展模式正面临一个越来越严峻的挑战:数据枯竭。随着AI对训练数据的依赖不断增加,数据来源的增长却逐渐放缓,可能会导致训练数据的可用性难以满足需求。

数据增长缓慢与挑战

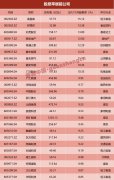

根据《Nature》上的一篇文章,尽管AI模型,尤其是大型语言模型(如ChatGPT),的训练数据在近几年爆炸性增长,但这一趋势正在面临挑战。Epoch AI的研究显示,AI训练数据集的规模预计将在2028年达到公开在线文本的总量,这意味着,AI可能在未来4年内耗尽现有的训练数据资源。与此同时,网络内容的增长速度却相对缓慢,Villalobos的研究估计,现有网络内容每年增长不到10%,而AI所需的训练数据集则以每年翻倍的速度扩张。

数据来源受限与版权问题

除了数据增长的速度放缓外,数据的来源也面临越来越多的限制。许多数据拥有者,尤其是报纸出版商,开始限制其内容的使用,进一步加剧了数据的获取难度。部分网站还通过技术手段,如使用软件代码或修改服务条款,阻止AI公司通过网络爬虫抓取数据。此外,版权争议成为一个日益严重的问题。例如,《纽约时报》已对OpenAI及其合作伙伴微软提起了版权侵权诉讼,这些诉讼可能进一步限制AI开发者,尤其是资金有限的学术界获取所需的数据。

应对数据枯竭的潜在策略

为了应对数据枯竭的问题,AI研究人员和开发者正在探索几种可能的解决方案:

利用非公开数据:包括WhatsApp消息、YouTube视频的文字稿等。这些数据尚未公开,但其合法性仍存在不确定性,可能会引发版权和隐私问题。

聚焦特定领域数据:例如天文数据或基因组数据,这些领域的数据正迅速增长,虽然这些数据的广泛应用于训练大规模语言模型的适用性尚不清楚。

利用多模态数据:扩展AI模型在处理未标记的视频或图像数据方面的能力,可以打开更丰富的数据来源。通过结合视频、图像等多模态数据,AI可以在多元化的信息源中获得更多学习机会。

生成合成数据:AI公司可以通过付费让用户生成内容,或者使用AI自身生成合成数据。然而,合成数据可能带有偏差和错误,可能影响模型训练的准确性。

转向多模态数据的未来发展

《Nature》文章还指出,AI模型目前大多依赖文字数据进行训练。然而,单纯依靠文字数据可能不足以实现真正的人类级AI。例如,Meta首席AI科学家Yann LeCun曾指出,一个四岁的孩子仅仅通过观察周围的世界所吸收的数据量,就远远超过了现代大型语言模型的训练数据量。

为了推动AI的下一步发展,未来的关键可能在于多模态学习,即从单纯的文字数据转向更丰富的数据形式,如视频、图像甚至感官体验等。这将需要开发更强大的AI模型和算法,以有效地处理和学习这些复杂、多样化的数据形式。

总结

面对数据枯竭的挑战,AI领域正在积极寻求多种应对策略。通过结合非公开数据、特定领域数据、多模态数据以及合成数据等方式,AI开发者希望能够继续推动技术的突破。然而,随着数据源逐渐枯竭,AI的未来发展可能会更加依赖于跨越单一数据模式的多元化学习方式,转向更加丰富的数据来源和处理方法。